谷歌联手伯克利给机器人上网课!观看8位医生手术视频学缝合

最近在Google Brain,英特尔还有UC伯克利的合作研究中,研究人员通过用手术教学视频来对机器人进行“训练”,让其能模仿手术过程。

前段时间,文摘菌曾提过价值53万一只的波士顿动力机器狗,也有进行太空探索的昆虫机器人,万万没想到的是,这次来了一个和大家一样上网课的机器人。

不知道你有没有想过这种场景,去医院做手术时,医生助手已经不是可爱的护士小姐姐,而是两只冷冰冰的机械臂,以快准狠的手法帮你缝合伤口。

最近在Google Brain,英特尔还有UC伯克利的合作研究中,研究人员通过用手术教学视频来对机器人进行“训练”,让其能模仿手术过程。

之前,UC伯克利的教授有用过YouTube视频指导机器人学习各种动作(比如跳跃和跳舞), 而Google则是有训练机器人理解场景中的深度还有动作。

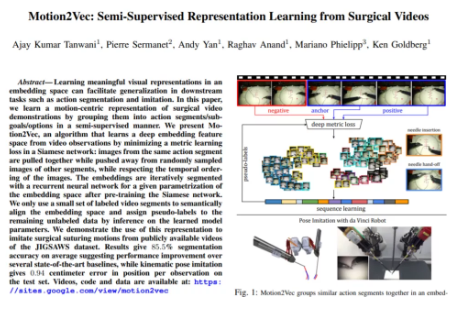

于是这次的团队,决定将之前的研究成果结合起来,应用于最新项目Motion2Vec。

Motion2Vec:机器人也要上网课

Motion2Vec算法,能用真实手术视频来指导机器人学习相关手术动作。

在最近发布的论文里,研究人员简单介绍了他们如何用YouTube视频来训练两臂达芬奇(da Vinci)机器人在针刺机上进行缝合操作。

它从模仿学习的视频演示中,获得以运动为中心的操作技能。其中表示的算法一致性、可解释性和监督学习的负担是该项目模仿学习中的关键问题,毕竟通常很难精确地描述定义一个片段和标记的内容。

论文地址:

http://www.ajaytanwani.com/docs/Tanwani_Motion2Vec_arxiv_2020.pdf

首先研究人员尝试将一小段被标记的视频进行分类,比如手术缝合任务分解成分段动作, 手术的针头刺入、拔针、针头脱落等动作。

这个分解过程有点类似于语音识别和合成问题,视频其中单词和句子是由音素和基于音素的片段合成的。 这部分会涉及到其它的相关领域,包括计算机视觉中的活动识别、强化学习以及自然语言处理中的词性标注。

然后,研究的重点是以半监督的方式从视频演示中提取动作表示,进行动作分割和模仿任务。

在监督学习的过程中,可能存在不受控制的因素,比如照明的强度,相机的机位,动作的顺序这些对机器人开启自主学习来说都是挑战。

在我们人类看来是很简单的操作,比如举起手术针,穿刺皮肤,但机器人不明白这些,在它们的系统认知里,就是两个物体正在进行相互纠缠的运动。

所以研究人员需要把视频的动作分解成小块,然后将相似动作段的图像像素放在一个组合里,对机器人所承载的模型进行训练。比如尝试使用递归神经网络来训练和预测,并使用训练结果来优化机器人的动作幅度,比如缝合对齐的精度。

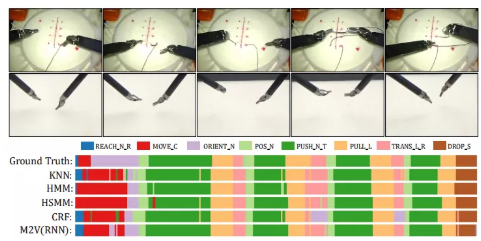

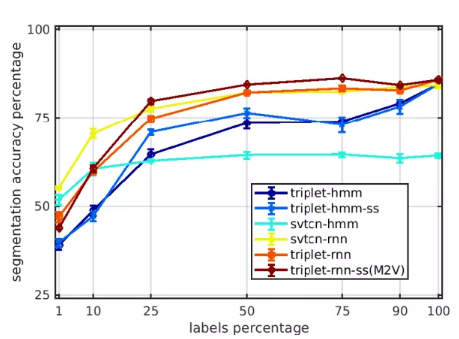

通过尝试KNN、HMM、HSMM、CRF和RNN进行对比,其中,KNN、HMM、HSMM是无监督的模式,而CRF和RNN采用的是有监督的模式。

结果表明是KNN与RNN两者的结果是比较好的。

由于训练采用的是JIGSAWS 数据集,其中包含3个手术任务的视频演示,分别是缝合、穿针和打结。所以在这次测试中,只有机器人尝试模拟缝合运动,并没有考虑更多的技术建模或者其它的问题。

除此之外,数据集里的视频演示并不只有一位医师,而是由8位技术等级不同的外科医师组成,所以这会产生一个问题,不同的医师,习惯可能会不同。而机器人正是要学习所有医师的缝合视频。

结果表明,与KNN相比,RNN,也就是M2V采用的模型,看上去结果是最好的。呈现的时间段比较一致。

如果采用分割精度来进行比较的话,仍旧是M2V算法领先于其它有标记和无监督的模型。当然结果平均超过5次迭代。

该研究主要是用了Siamese网络结构,这是一种让两个或多个网络分享同一套参数的深度学习架构。一般在比较和评估数据之间关系时, Siamese结构都是最佳选择,所以之前也已广泛用于面部检测,签名验证还有语言检测等领域。

UC伯克利的实验室负责人肯·戈德伯格说道,对于这类的深度学习项目YouTube上的训练数据非常丰富。

“在YouTube上每分钟能获得500个小时的视频材料,这简直就是一个大宝库。”

他说,“而对于这些视频,人类几乎任何人都能看懂且理解,但机器人目前却无法理解—只能单纯地将其看作是像素流。因此,这项工作的首要目标就是让机器人弄清这些像素的含义。主要就是看视频,然后对其进行分析, 最后能将视频切成有意义的序列。”

对于缝合任务,该团队仅用了78个医学教学视频就能训练其AI引擎进行相同操作,而且声称有接近85%的成功率。

这意味着,之后机器人或许能在外科手术过程中执行一些基础的重复性任务,而能让外科医生将时间和精力集中在更精细的手术步骤上。

那机器人短时间内会取代外科医生吗?

“现在还远没到那个地步” 。戈德伯格说,“但至少,现在已经正朝着具备外科医生能力的方向发展了。这意味着它能迅速地观察大局,指出哪里需要一排缝合线,或哪里需要特殊缝合。” 戈德伯格继续说,“接着,当机器人能基本完成这些的时候,外科医生就能够更轻松一些,获得更多休息时间,而且能专注于手术中更复杂或精细的地方。”

近年来机器学习为生物技术相关做了很大贡献, AI快速处理大数据的能力使很多方面都获得了进步,比如基于CAT扫描检测肺癌和中风风险,基于EKG和MRI图像计算心脏病和心脏骤停风险,从照片对皮肤病变分类,还有检测眼部图像中的糖尿病迹象方面。

在新冠流行期间,AI还帮助科学家寻找可以抑制COVID-19传播的药物,并试图找到治愈方法和疫苗。

看视频学习,在我们人类看来是一件极其容易的事情,但对于机器人来说,却需要很多人去帮助它学习,在这个学习的过程中,会耗费巨大的人力物力。

可一旦等它学会了,它就可以帮助我们完成许多不可能的事情,

期待机器人早日成为人类的好帮手!将不可能变成可能!

相关报道:

https://techxplore.com/news/2020-06-intel-google-uc-berekely-ai.html

https://sites.google.com/view/motion2vec

本文转载自其他网站,不代表大健康派观点和立场。如有内容和图片的著作权异议,请及时联系我们(邮箱:scarlet.s@djkpai.com)

关注大健康Pai 官方微信:djkpai我们将定期推送医健科技产业最新资讯